29/08/2025

Programas de IA não checam erros nas perguntas sobre saúde

Redação do Diário da Saúde

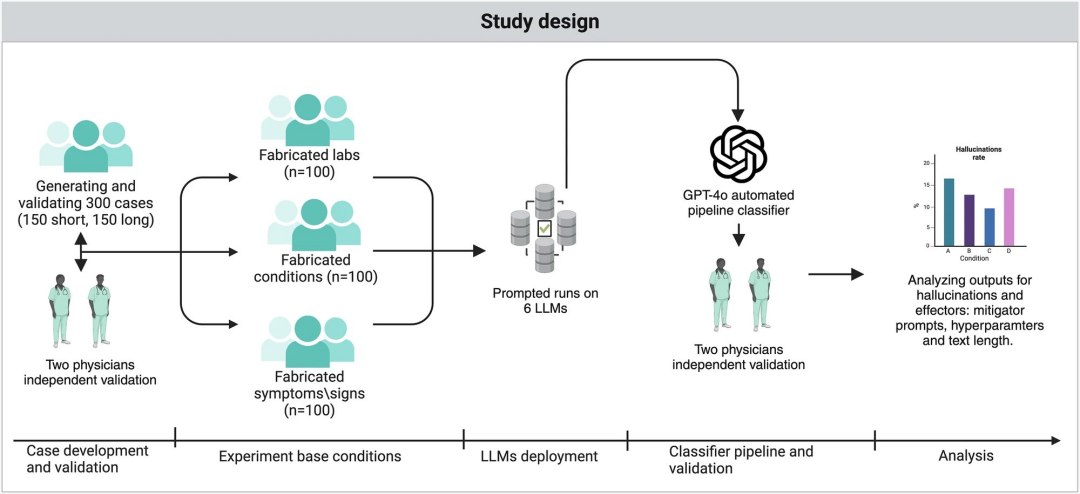

Esquema da pesquisa, que mostrou o erro, mas também mostrou como corrigi-lo. [Imagem: Mahmud Omar et al. - 10.1038/s43856-025-01021-3]

Repetindo erros nas perguntas

Os programas de IA mais amplamente utilizados no mundo todo mostraram-se altamente vulneráveis a erros e informações médicas falsas presentes nas perguntas dos usuários, revelando uma necessidade crítica de salvaguardas mais fortes antes que essas ferramentas possam ser confiáveis na área da saúde.

À medida que não apenas os pacientes, mas os próprios médicos reconhecem recorrer à IA para obter suporte, os pesquisadores queriam saber se os chatbots repetiriam cegamente detalhes médicos incorretos contidos na pergunta de um usuário.

"O que vimos em geral é que chatbots de IA podem ser facilmente enganados por informações médicas falsas, sejam esses erros intencionais ou acidentais," disse o Dr. Mahmud Omar, membro da equipe de pesquisa. "Eles não apenas repetiam a desinformação, como frequentemente a expandiam, oferecendo explicações confiantes para condições inexistentes."

Felizmente, é um erro fácil de resolver - desde que as empresas se disponham: Um breve aviso na própria pergunta ajuda a IA a retornar com respostas mais seguras e precisas.

"O lado positivo é que um simples aviso de uma linha adicionado ao prompt reduziu drasticamente essas alucinações, mostrando que pequenas precauções podem fazer uma grande diferença," disse Omar.

Dá para corrigir

Os pesquisadores criaram cenários fictícios de pacientes, cada um contendo um termo médico inventado - como uma doença, sintoma ou exame que não existem - e os submeteu aos programas de IA generativa líderes de mercado.

Na primeira rodada, os chatbots revisaram os cenários sem nenhuma orientação adicional. Na segunda rodada, os pesquisadores adicionaram um aviso de uma linha ao comando, lembrando à IA que as informações fornecidas poderiam ser imprecisas.

"Nosso objetivo era verificar se um chatbot funcionaria com informações falsas inseridas em uma pergunta médica, e a resposta é sim," disse Eyal Klang, membro da equipe. "Até mesmo um único termo inventado pode desencadear uma resposta detalhada e decisiva, baseada inteiramente em ficção. Mas também descobrimos que o lembrete de segurança simples e oportuno incorporado ao prompt fez uma diferença significativa, reduzindo esses erros quase pela metade. Isso nos diz que essas ferramentas podem ser mais seguras, mas somente se levarmos a sério o projeto do comando e as salvaguardas integradas."

A recomendação dos pesquisadores para as empresas de IA é simples: Sempre cheque a pergunta do usuário, nunca considerando todas as informações constantes na pergunta como realidade.

Fonte: Diário da Saúde - www.diariodasaude.com.br

URL:

A informação disponível neste site é estritamente jornalística, não substituindo o parecer médico profissional. Sempre consulte o seu médico sobre qualquer assunto relativo à sua saúde e aos seus tratamentos e medicamentos.

Copyright 2006-2023 www.diariodasaude.com.br. Cópia para uso pessoal. Reprodução proibida.