Inteligência Artificial falha ao tentar diagnosticar pacientes

Redação do Diário da Saúde

[Imagem: OpenClipart-Vectors/Pixabay]

Falhas do diagnóstico automatizado

O aprendizado de máquina tem ajudado a entender os complexos padrões de atividade cerebral. Os cientistas então correlacionam esses padrões a comportamentos humanos, como memória de trabalho, traços como impulsividade e distúrbios como depressão.

E, com essas ferramentas, os cientistas podem criar modelos dessas relações; a teoria é que esses modelos sejam então usados para fazer previsões sobre o comportamento e a saúde de cada paciente individualmente.

Mas isso só funciona se os modelos representarem todas e cada uma das pessoas, o que é necessário para que eles possam ser aplicados a qualquer indivíduo. O grande problema é que várias pesquisas têm demonstrado que não é assim: Qualquer que seja o modelo que se utilize, há sempre uma parcela significativa de pessoas típicas às quais o modelo simplesmente não se encaixa.

Pesquisadores da Universidade de Yale (EUA) decidiram então examinar com quem esses modelos tendem a falhar, por que isso acontece e o que pode ser feito a respeito.

"Se quisermos mover esse tipo de trabalho para uma aplicação clínica, por exemplo, precisamos garantir que o modelo se aplique ao paciente sentado à nossa frente," resumiu a professora Abigail Greene, líder da equipe.

Modelos sem generabilidade

Os pesquisadores estão interessados em como os modelos podem fornecer uma caracterização psiquiátrica mais precisa, o que eles acham que pode ser alcançado de duas maneiras.

A primeira é categorizar melhor as populações de pacientes. Um diagnóstico de esquizofrenia, por exemplo, engloba uma série de sintomas e pode ser muito diferente de pessoa para pessoa. Uma compreensão mais profunda dos fundamentos neurais da esquizofrenia, incluindo seus sintomas e subcategorias, pode permitir que os pesquisadores agrupem os pacientes de uma maneira mais sutil.

Em segundo lugar, há traços como a impulsividade que são compartilhados por uma variedade de diagnósticos. Compreender a base neural da impulsividade pode ajudar os médicos a direcionar esse sintoma de forma mais eficaz, independentemente do diagnóstico da doença ao qual ele está ligado.

Mas, antes de tudo, os modelos precisam ser generalizáveis para todos. Quando a equipe partiu para os testes, os modelos previram corretamente o quão bem a maioria dos indivíduos pontuaria nesses quesitos. Contudo, para algumas pessoas, eles se mostraram não apenas imprecisos, mas errados mesmo, prevendo erroneamente que as pessoas pontuariam mal quando na verdade pontuavam bem, e vice-versa.

A equipe de pesquisa então analisou os pacientes que os modelos não conseguiram categorizar corretamente.

"Nós descobrimos que há uma consistência: Os mesmos indivíduos estavam sendo classificados erroneamente nas tarefas e nas análises," disse Greene. "E as pessoas classificadas incorretamente em um conjunto de dados tinham algo em comum com as pessoas classificadas incorretamente em outro conjunto de dados. Portanto, há realmente algo significativo em ser classificado incorretamente."

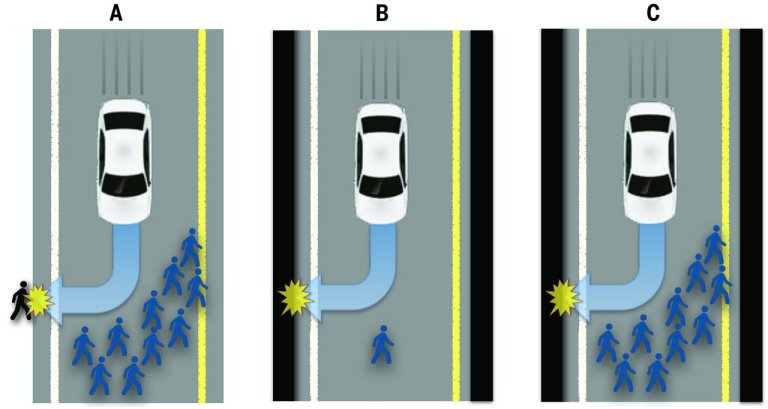

[Imagem: Bonnefon et al. - 10.1126/science.aaf2654]

Inteligência artificial reproduz estereótipos

Em seguida, os pesquisadores procuraram ver se essas classificações equivocadas semelhantes poderiam ser explicadas por diferenças nos cérebros desses indivíduos. Mas não houve diferenças consistentes.

Em vez disso, eles descobriram que as classificações incorretas estão relacionadas a fatores sociodemográficos, como idade e educação, e fatores clínicos, como gravidade dos sintomas.

Em última análise, eles concluíram que os modelos não refletem apenas a capacidade cognitiva; eles estão refletindo "perfis" mais complexos - uma espécie de mistura das habilidades cognitivas e vários fatores sociodemográficos e clínicos, explicou Greene.

O impacto dessa descoberta é maior do que parece, contestando uma tendência crescente no uso da inteligência artificial para diagnósticos médicos e, sobretudo, psicológicos e psiquiátricos: Esses modelos acabam reproduzindo o que os diagnósticos e avaliações iniciais atribuíram aos pacientes que foram analisados originalmente, quando o modelo estava sendo desenvolvido.

"E os modelos falharam com qualquer um que não se encaixasse nesse perfil estereotipado," concluiu a pesquisadora.

Artigo: Brain-phenotype models fail for individuals who defy sample stereotypes

Autores: Abigail S. Greene, Xilin Shen, Stephanie Noble, Corey Horien, C. Alice Hahn, Jagriti Arora, Fuyuze Tokoglu, Marisa N. Spann, Carmen I. Carrión, Daniel S. Barron, Gerard Sanacora, Vinod H. Srihari, Scott W. Woods, Dustin Scheinost, R. Todd Constable

Publicação: Nature

DOI: 10.1038/s41586-022-05118-w

| Ver mais notícias sobre os temas: | |||

Softwares | Preconceitos | Diagnósticos | |

| Ver todos os temas >> | |||

Brasileiros estão vivendo mais de 110 anos e os cientistas querem saber o porquê

Solução doce para a calvície? Stévia estimula crescimento capilar

Há vários caminhos para melhorar a saúde mental

Dormir menos de 7 horas pode reduzir anos da sua vida

Jovens talentosos estão sendo orientados da maneira errada

Descoberta forma de fortalecer resposta imunológica contra o câncer

Tagatose: Novo açúcar adoça sem as desvantagens habituais

Quarto mais frio ajuda recuperação do coração durante o sono

Bambu pode se tornar superalimento mundial

Novo material que destrói o câncer tem participação de cientista brasileira

Para viver mais, pratique vários tipos de exercícios, e não muito de um só

Nossa memória não funciona do modo como os cientistas pensavam

Ossos podem ter benefícios do exercício sem que seja necessário se movimentar

Casca de romã combate infecções na pele

Infarto não é evento isolado, envolvendo cérebro, coração e sistema imune

Curativo com antioxidante destrói bactérias melhor que antibiótico

Sensores sem bateria monitoram sua saúde sem lhe incomodar

Novo material que destrói o câncer tem participação de cientista brasileira

Combinação de químicos seguros gera mistura tóxica por gerações

Exposição à luz natural melhora saúde metabólica e diabetes

Vacina do Butantan contra dengue grave tem 89% de proteção

Brasil tem primeiras mortes por febre oropouche no mundo

Censo 2022: Por que várias cidades brasileiras tiveram diminuição da população?

Brasil tem primeiro caso de gripe aviária em aves domésticas

Brasil decreta emergência zoossanitária devido à gripe aviária

Proibido o uso de animais em pesquisas de cosméticos e higiene pessoal

A informação disponível neste site é estritamente jornalística, não substituindo o parecer médico profissional. Sempre consulte o seu médico sobre qualquer assunto relativo à sua saúde e aos seus tratamentos e medicamentos.

Copyright 2006-2026 www.diariodasaude.com.br. Todos os direitos reservados para os respectivos detentores das marcas. Reprodução proibida.